El impacto de la IA en el periodismo: Empleos

(13 de octubre, 2023). Con información de The Conversation. La Inteligencia Artificial (IA) ya era un elemento comúnmente utilizado en el ámbito del software y las aplicaciones móviles, pero su popularidad experimentó un notable incremento en el año 2023 con la introducción del robot conversacional conocido como ChatGPT, desarrollado por la prestigiosa empresa OpenAI.

El periodismo no se exime de integrar a su staff programas de IA para potenciar su producción informativa. Los robots periodistas, como el caso de Gabriele, que es empleado por la agencia EFE, ya se encuentran activos y son capaces de generar texto con una sintaxis, coherencia y exposición de ideas que envidiarían algunos redactores experimentados.

Otras herramientas, como Tableau, facilitan la organización y el análisis eficiente de grandes conjuntos de datos en un período de tiempo reducido, lo que resulta especialmente útil en investigaciones periodísticas complejas, como el caso de los Papeles de Pandora.

Otras herramientas, como Tableau, facilitan la organización y el análisis eficiente de grandes conjuntos de datos en un período de tiempo reducido, lo que resulta especialmente útil en investigaciones periodísticas complejas, como el caso de los Papeles de Pandora.

En el ámbito del periodismo, la IA ha ganado terreno de manera significativa desde el año 2014, cuando el periódico Los Angeles Times adoptó el software denominado Quakebot para la generación automatizada de informes acerca de eventos sísmicos.

Uno de los motivos detrás de este crecimiento se relaciona con su capacidad para mejorar la eficiencia, reducir el consumo de tiempo y costos, al automatizar tareas rutinarias en el proceso de producción de contenido noticioso. Esto incluye la transcripción de grabaciones de audio, redacción de resúmenes y noticias breves, así como la distribución de boletines informativos. Además, esta tecnología amplía el potencial para ofrecer contenidos personalizados y realizar análisis de audiencia más detallados.

Impacto en los empleos de periodistas

Tomando en cuenta el impacto de la IA en el proceso de construcción de contenidos periodísticos, se vislumbra que quienes se desempeñan en eslabones que no otorgan valor agregado serán susceptibles de ser despedidos. Camarógrafos, community managers, editores web o personal de cabinas y estudios televisivos, tales como switchers, operadores de audio, floor managers o tituladores, podrían ser sustituidos por herramientas automatizadas.

¿Qué sentido tiene cubrir presencialmente una rueda de prensa, si la IA genera el texto a partir de la transmisión? ¿Por qué perder tiempo en transcripciones? ¿Para qué destinar personal a la publicación de resultados deportivos o indicadores financieros, si la IA puede hacerlo por nosotros?

Incluso reporteros dedicados al diarismo o presentadores de noticias que se limitan a leer en un teleprompter podrían ser prescindibles. Si el periodista se enfoca en maquilar piezas elementales o en información únicamente para la vista o el oído, entonces “puede ser sustituido tanto por los robots como por los periodistas ciudadanos que no han pasado por una universidad y que obedecen a un instinto primario por la noticia”.

Desde antes que la IA se popularizara, las empresas periodísticas ya han recurrido a recortes de costos y nóminas ante la crisis que sufren por el cambio de modelos de negocios. La Sociedad Interamericana de Prensa documentó que, en México, medios como TV Azteca, Grupo Expansión, Editorial Travesías, Crónica y Record anunciaron despidos, recortes de salarios o suspensiones temporales de circulación. En Brasil, al menos 21 medios regionales hicieron lo propio.

Éste es un tema de enorme interés para el periodismo en general pero, sobre todo, para los periodistas.

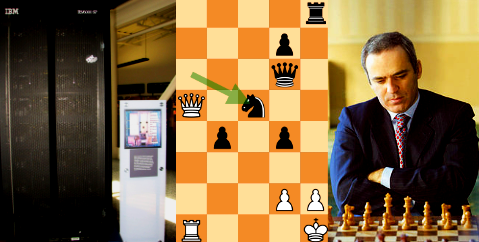

La «máquina de Turing» (1936), un aparato imaginario capaz de imitar procesos inteligentes humanos tan sólo si se presentan como “algoritmos”, se considera el gran predecesor de las computadoras y de los programas actuales. Deep Blue, el sistema computacional de IBM que «derrotó» a Gary Kasparov en 1997, es una máquina de Turing porque produce millardos de configuraciones complejas a partir de reglas simples que se agregan y concatenan, de modo que parecen realizadas, no sólo por un humano, sino por uno superdotado.

La «máquina de Turing» (1936), un aparato imaginario capaz de imitar procesos inteligentes humanos tan sólo si se presentan como “algoritmos”, se considera el gran predecesor de las computadoras y de los programas actuales. Deep Blue, el sistema computacional de IBM que «derrotó» a Gary Kasparov en 1997, es una máquina de Turing porque produce millardos de configuraciones complejas a partir de reglas simples que se agregan y concatenan, de modo que parecen realizadas, no sólo por un humano, sino por uno superdotado.