El Papa Francisco alertó sobre una posible dictadura tecnológica de la IA ¿tiene razón?

|

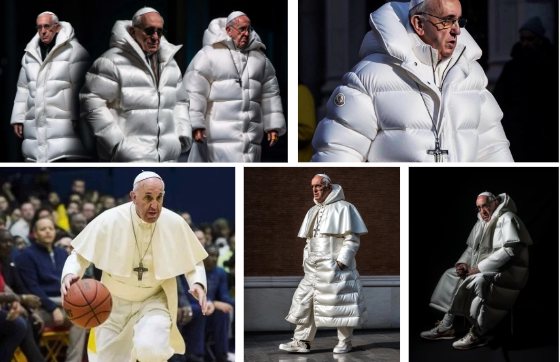

(FNN – 15 de diciembre, 2023). En su discurso en el Día Mundial de la Paz, el Papa Francisco se refirió a la IA desde el Vaticano, advirtiendo -entre otras cosas- que podía generar «una dictadura tecnológica». Además, incrementaría las desigualdades sociales, dañaría las democracias y socavaría la paz. Le faltó poco para equipararla con el Armagedón del Apocalipsis, que señalaría el fin de la humanidad tal cual la conocemos. No obstante, fue razonable al aceptar que tal tecnología no podría ser prohibida o regulada a un punto que la estrangulara, pero sí a que debe apuntarse a las mejores prácticas. Su recomendación fue reglamentación, si era posible, internacional. El Sumo Pontífice destacó que la IA puede tener muchas caras, desde las auspiciosas hasta las muy peligrosas. Eso es cierto, y lo vemos en casi todas las tecnologías disruptivas: una cámara, por decir algo, puede registrar bellos paisajes o pornografía. No obstante, tiene razón el Papa al destacar que la IA tiene poderosos procesos que pueden falsificar realidades, hacer que alguien pase un examen sin haber estudiado ni una letra o falsificar una noticia con imágenes alteradas. La revista Wired explica que:

El máximo representante del Vaticano explicó que la inteligencia artificial puede tomar diversas formas en función de los objetivos e intereses de quienes desarrollan y usan la tecnología. “La inteligencia artificial, por tanto, debe ser entendida como una galaxia de realidades distintas y no podemos presumir a priori que su desarrollo aporte una contribución benéfica al futuro de la humanidad y a la paz entre los pueblos. Tal resultado positivo sólo será posible si somos capaces de actuar de forma responsable y de respetar los valores humanos fundamentales”, sentenció. El Papa ícono de modaRecordemos que en marzo pasado, el Papa fue objeto de una «sesión de fotos» trucadas con IA, producidas por Pablo Xavier, un joven de Chicago que confesó haber alterado las fotos en medio de un «viaje» de hongos alucinógenos. Francisco I sabe del poder de la IA y la manipulación de la realidad pictórica.

|

_____________________________________________

Imagen: Google Images, fotos de uso abierto.

Al Jazeera discutió las implicaciones del uso reportado de IA por parte de Israel en la guerra de Gaza, resaltando preocupaciones sobre el impacto potencial en las poblaciones civiles en Gaza.

Al Jazeera discutió las implicaciones del uso reportado de IA por parte de Israel en la guerra de Gaza, resaltando preocupaciones sobre el impacto potencial en las poblaciones civiles en Gaza.